Nvidia-CEO Jensen Huang sagt, dass die Leistung der KI-Chips seines Unternehmens schneller voranschreitet als die historischen Raten des Moore-Gesetzes, das jahrzehntelangen Fortschritt in der Computertechnologie vorangetrieben hat.

'Unsere Systeme entwickeln sich viel schneller als das Moore-Gesetz', sagte Huang in einem Interview mit TechCrunch am Dienstagmorgen, nachdem er eine Keynote vor einem Publikum von 10.000 Personen auf der CES in Las Vegas gehalten hatte.

In den letzten Jahren hat sich das Moore-Gesetz verlangsamt. Huang behauptet jedoch, dass die KI-Chips von Nvidia ihr eigenes beschleunigtes Tempo beibehalten; Das Unternehmen gibt an, dass sein neuester Datacenter-Superchip für das Ausführen von KI-Inferenz-Workloads mehr als 30 Mal schneller ist als seine vorherige Generation.

'Wir können die Architektur, den Chip, das System, die Bibliotheken und die Algorithmen gleichzeitig entwickeln', sagte Huang. 'Wenn Sie das tun, können Sie schneller als das Moore-Gesetz vorankommen, weil Sie über den gesamten Stapel innovieren können.'

Die kühne Behauptung des Nvidia-CEOs erfolgt zu einer Zeit, in der viele Fragen stellen, ob der Fortschritt der KI ins Stocken geraten ist. Führende KI-Labors - wie Google, OpenAI und Anthropic - verwenden Nvidia-KI-Chips, um ihre KI-Modelle zu trainieren und auszuführen, und Fortschritte bei diesen Chips würden wahrscheinlich zu weiteren Fortschritten bei den Fähigkeiten der KI-Modelle führen.

Dies ist nicht das erste Mal, dass Huang angedeutet hat, dass Nvidia das Moore-Gesetz überschreitet. In einem Podcast im November deutete Huang an, dass die KI-Welt auf dem Weg zum 'hyper-Moore-Gesetz' ist.

Huang weist die Idee zurück, dass der Fortschritt der KI nachlässt. Stattdessen behauptet er, dass es jetzt drei aktive KI-Skalierungsgesetze gibt: Pre-Training, die anfängliche Trainingsphase, in der KI-Modelle Muster aus großen Datensätzen lernen; Post-Training, das ein KI-Modell durch Methoden wie menschliches Feedback feinabstimmt; und Testzeit-Berechnung, die während der Inferenzphase stattfindet und einem KI-Modell mehr Zeit gibt, nach jeder Frage 'nachzudenken'.

'Das Moore-Gesetz war in der Geschichte der Computertechnologie so wichtig, weil es die Kosten für die Rechenleistung gesenkt hat', sagte Huang gegenüber TechCrunch. 'Das Gleiche wird bei der Inferenz passieren, wo wir die Leistung steigern und infolgedessen die Kosten für die Inferenz geringer sein werden.'

(Natürlich ist Nvidia durch den Boom in der KI zur wertvollsten Firma der Welt geworden, daher ist es für Huang von Vorteil, das zu sagen.)

Nvidia-H100s waren der Chip der Wahl für Technologieunternehmen, die KI-Modelle trainieren wollten, aber jetzt, da sich Technologieunternehmen mehr auf die Inferenz konzentrieren, wird in Frage gestellt, ob die teuren Chips von Nvidia weiterhin die Spitze halten werden.

KI-Modelle, die Testzeit-Berechnung verwenden, sind heute teuer zu betreiben. Es besteht die Sorge, dass das o3-Modell von OpenAI, das eine vergrößerte Version der Testzeit-Berechnung verwendet, für die meisten Menschen zu teuer sein könnte. Beispielsweise gab OpenAI fast 20 US-Dollar pro Aufgabe aus, um menschenähnliche Ergebnisse bei einem Test zur allgemeinen Intelligenz zu erzielen. Ein ChatGPT Plus-Abonnement kostet 20 US-Dollar für einen ganzen Monat Nutzung.

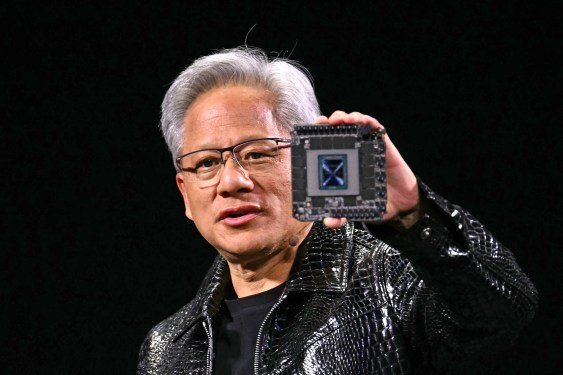

Huang hielt während der Keynote am Montag Nvidias neuesten Datacenter-Superchip, den GB200 NVL72, wie einen Schild hoch. Dieser Chip ist beim Ausführen von KI-Inferenz-Workloads 30 bis 40 Mal schneller als Nvidias bisherige Bestseller-Chips, der H100. Huang sagt, dass dieser Leistungssprung bedeutet, dass KI-Reasoning-Modelle wie OpenAIs o3, die während der Inferenzphase eine erhebliche Menge an Berechnungen verwenden, im Laufe der Zeit günstiger werden.

Huang konzentriert sich insgesamt darauf, leistungsstärkere Chips zu entwickeln, und leistungsstärkere Chips führen langfristig zu niedrigeren Preisen.

'Die direkte und sofortige Lösung für die Testzeit-Berechnung, sowohl in Bezug auf Leistung als auch auf erschwingliche Kosten, besteht darin, unsere Rechenleistung zu erhöhen', sagte Huang zu TechCrunch. Er merkte an, dass KI-Reasoning-Modelle langfristig genutzt werden könnten, um bessere Daten für das Pre-Training und das Post-Training von KI-Modellen zu erstellen.

Wir haben sicherlich im letzten Jahr einen Preisverfall bei KI-Modellen erlebt, teilweise aufgrund von Durchbrüchen bei der Hardeware von Unternehmen wie Nvidia. Huang sagt, dass dies ein Trend ist, den er auch bei KI-Reasoning-Modellen erwartet, obwohl die ersten Versionen, die wir von OpenAI gesehen haben, eher teuer waren.

Insgesamt behauptete Huang, dass seine KI-Chips heute 1000 Mal besser sind als die vor 10 Jahren hergestellten. Das ist ein viel schnelleres Tempo als das von Moore's Law gesetzte Standard, das Huang zufolge noch lange nicht enden wird.

TechCrunch hat einen auf KI fokussierten Newsletter! Melden Sie sich hier an, um ihn jeden Mittwoch in Ihrem Posteingang zu erhalten.